LM studioを使ってインストールしたgpt-oss 20bに、Docker DesktopのMCP Toolkitを使用してMCPサーバーをインストールしWeb検索機能を追加しました。

この記事では、LM studioとgpt-oss 20bの概要とDocker DesktopのMCP Toolkitを使用してDuckDuckGo MCPサーバーをインストールして使う方法を記載しています。

gpt-oss にMCP ToolkitでWeb検索機能を追加!

LM studioとは

LM Studio は、ローカル環境で大規模言語モデル(LLM)を実行・管理できるデスクトップアプリケーションです。

ユーザーが自分のPC上でモデルを動かせるため、クラウド依存を避けつつ、高速でプライバシーに配慮したAI利用が可能になります。

主な特徴

- ローカル推論

インターネット接続なしでもモデルを実行可能。データが外部サーバーに送信されないため、機密性の高いプロジェクトやオフライン環境でも利用できます。 - マルチモデル対応

GPT系やOSSモデル(例:gpt-oss 20B)のほか、LLaMA、MistralなどHugging Face互換のモデルも導入可能。 - MCP(Model Context Protocol)対応

外部ツールやサーバーを「MCPサーバー」として接続でき、Web検索やAPI連携など機能を拡張可能。 - GPU活用

NVIDIA GPUがある環境では、GPU推論を有効化して高速化できる。 - 直感的なUI

モデル管理、会話履歴、ツール設定がわかりやすいGUIで操作可能。

利用イメージ

- アプリ上でモデルを選択・起動

- MCPサーバーを接続し、Web検索やデータ取得機能を追加

- チャット形式でAIとやり取りしつつ、外部データを組み込んだ回答を生成

gpt-oss 20bとは

gpt-oss 20b は、オープンソースとして公開されている大規模言語モデル(LLM)の一つで、約200億(20B)パラメータを持つ高性能なテキスト生成モデルです。

その名の通り「GPT系」のアーキテクチャをベースにしており、文章生成、要約、質問応答、コード補完など幅広い自然言語処理タスクに対応します。

主な特徴

- オープンソースモデル

モデル構造や学習済み重みが一般公開されており、商用・研究目的で自由に利用や改変が可能です。 - 高性能と汎用性

20Bという大規模パラメータ数により、高い文章生成品質と多分野対応力を持っています。 - ローカル推論対応

LM Studioなどの環境で動かすことで、クラウドに依存せずオフラインでも利用可能。 - カスタマイズ容易

独自データでのファインチューニングやプロンプト最適化が比較的容易に行えます。 - 多言語対応

学習データに多言語が含まれており、日本語を含む複数言語での対話や文章生成が可能です。

利用例

- 知識検索+要約

MCPサーバー(例:DuckDuckGo MCP)と組み合わせ、Web検索結果を読み込み要約。 - ビジネス文書作成

メール、提案書、記事などの自動生成。 - 技術支援

プログラムコードの補完やデバッグ支援。 - 教育用途

語学学習や専門分野のトレーニング教材作成。

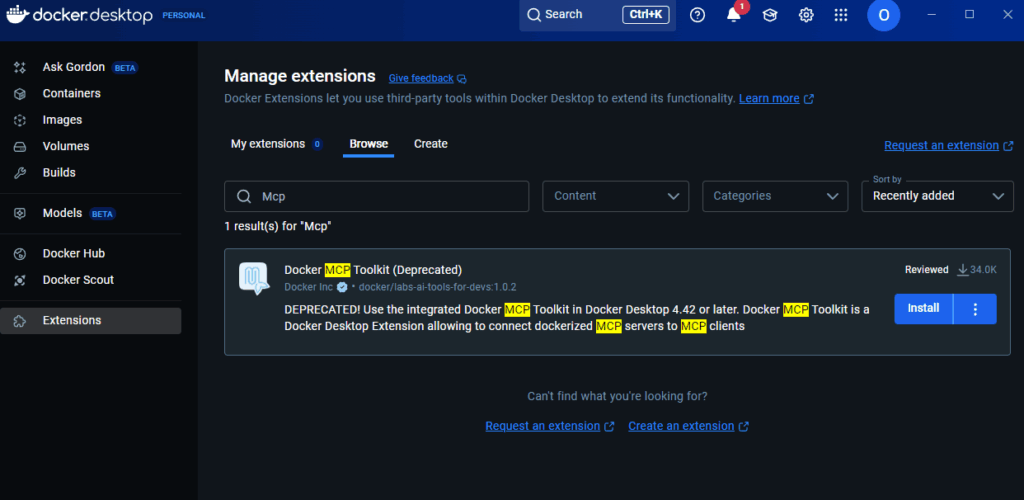

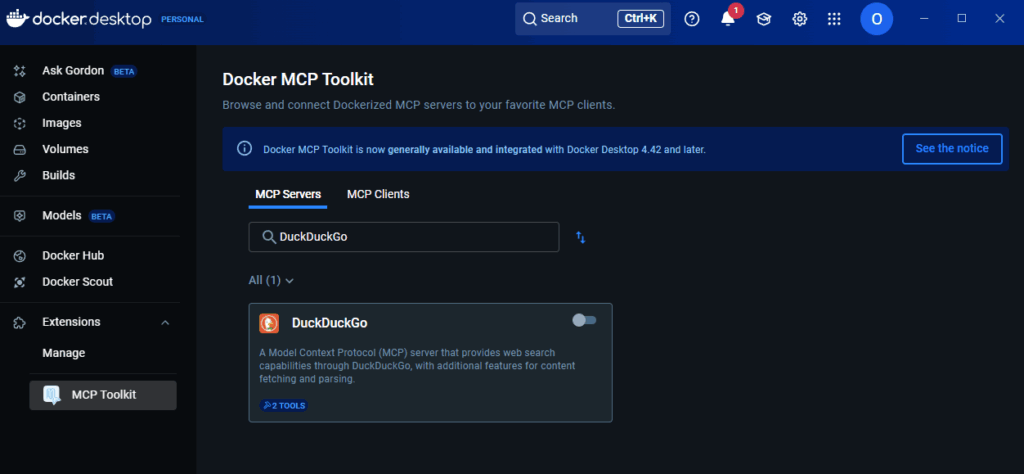

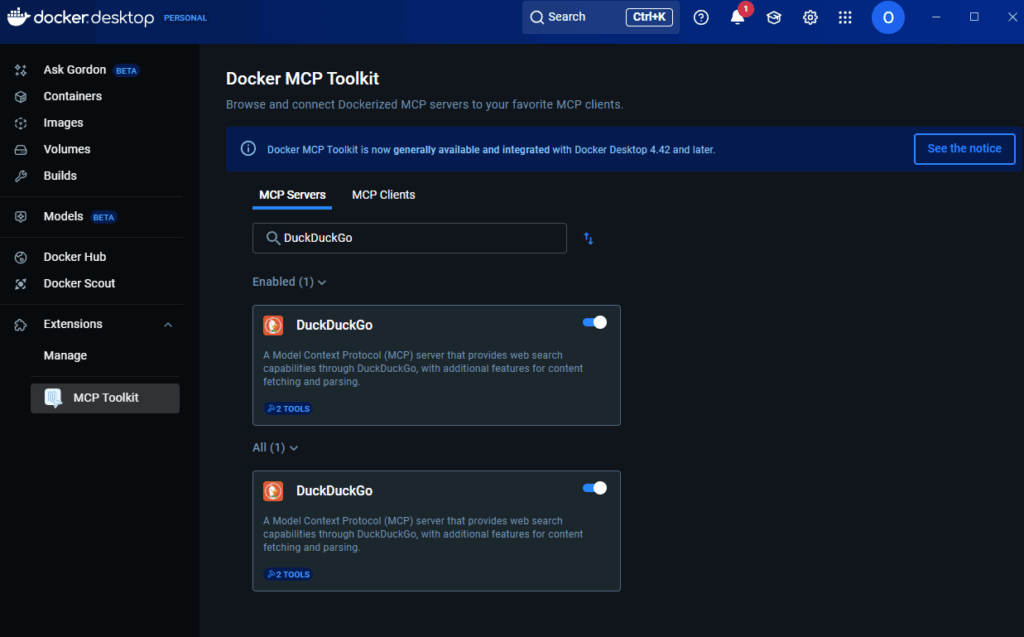

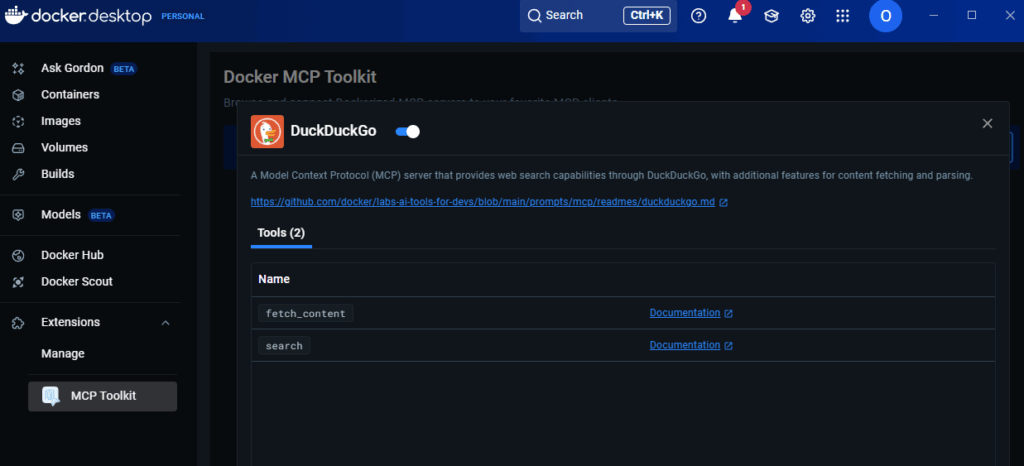

MCP ToolkitでMCPサーバーをインストール

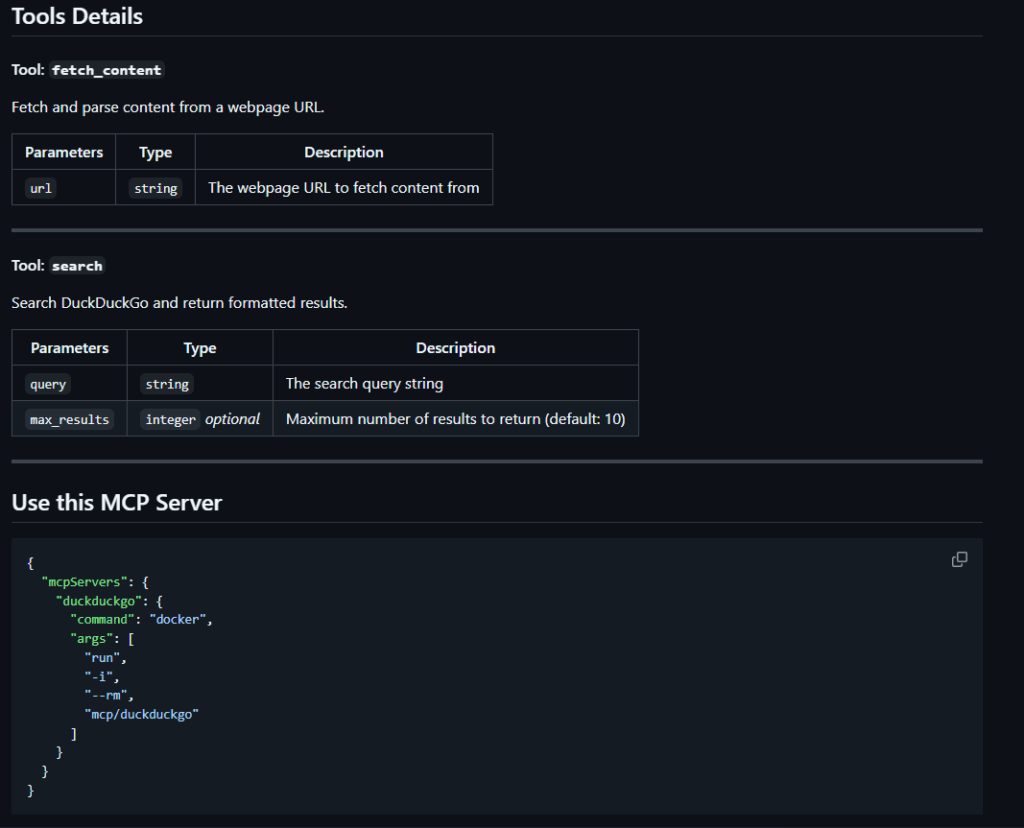

LM Studioにインストールしたgpt-oss 20bにDuckDuckGo MCPサーバーをインストールしてWeb検索機能を追加します。

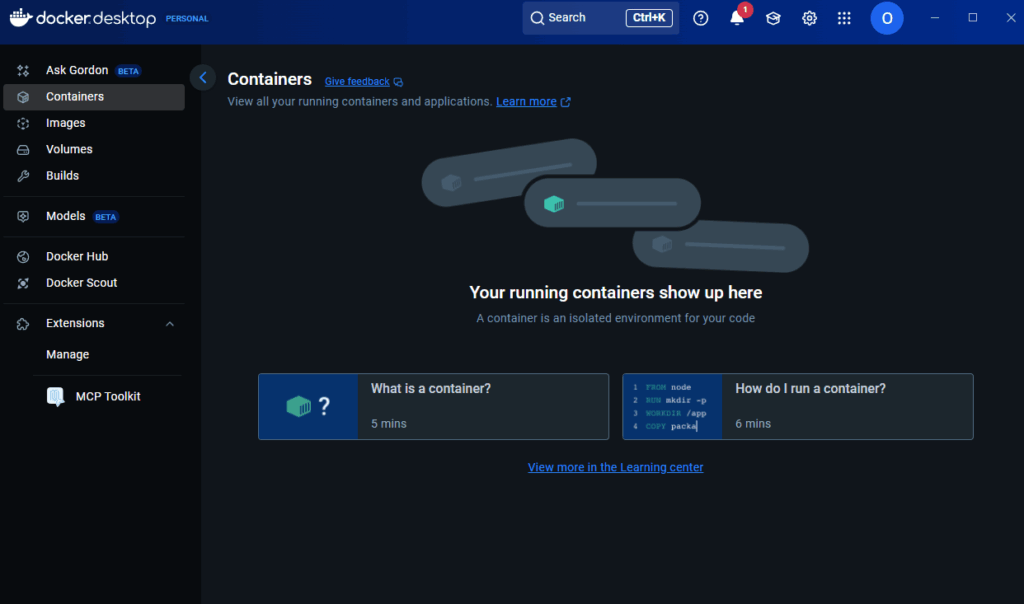

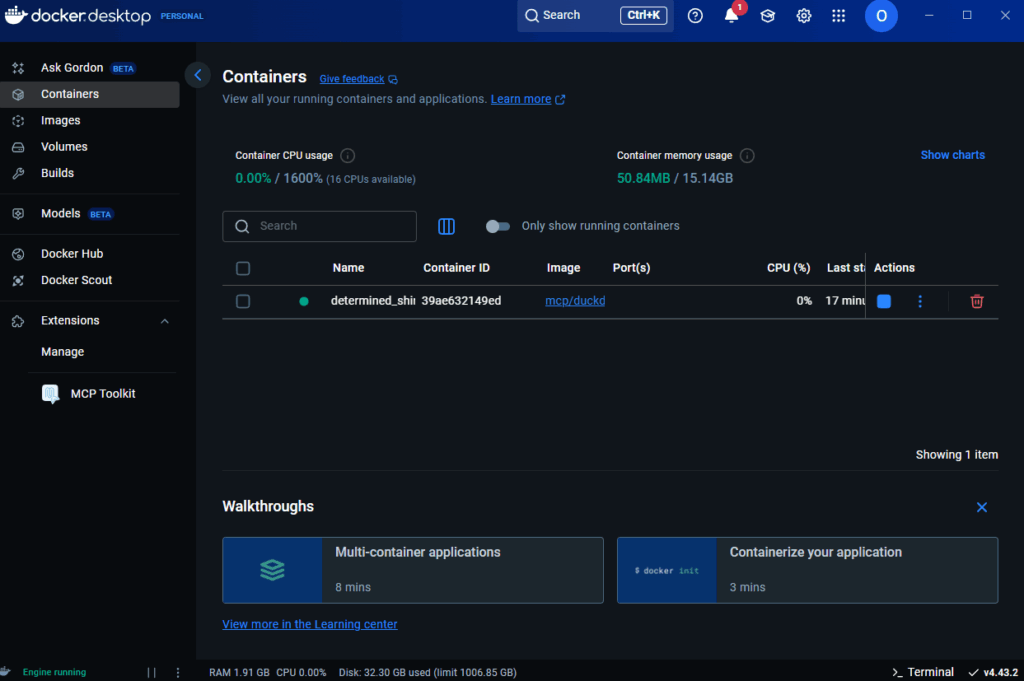

Docker Desktopでの作業

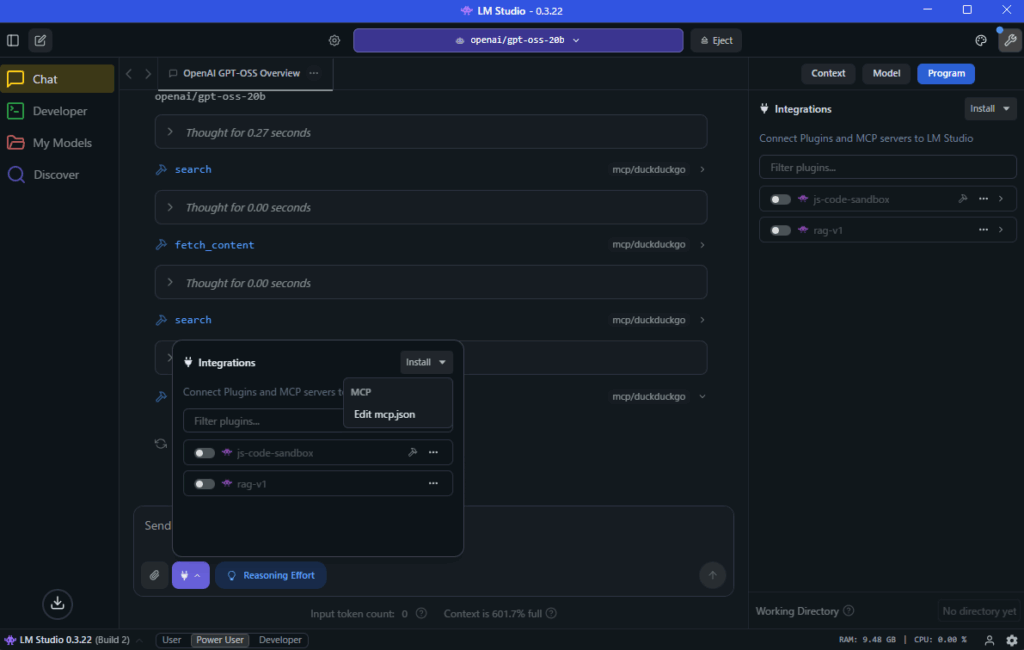

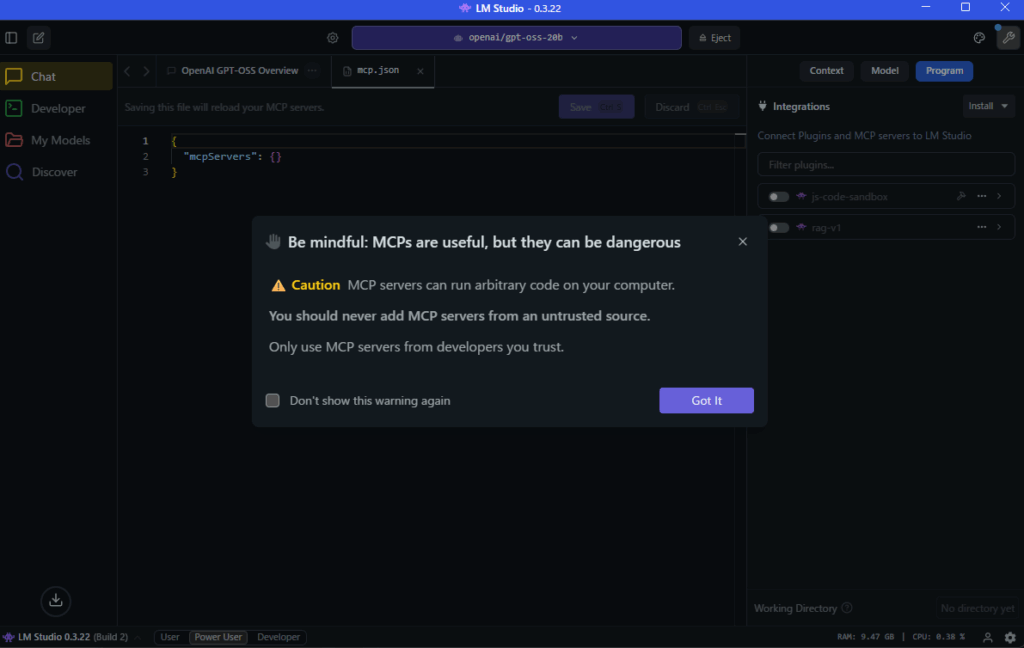

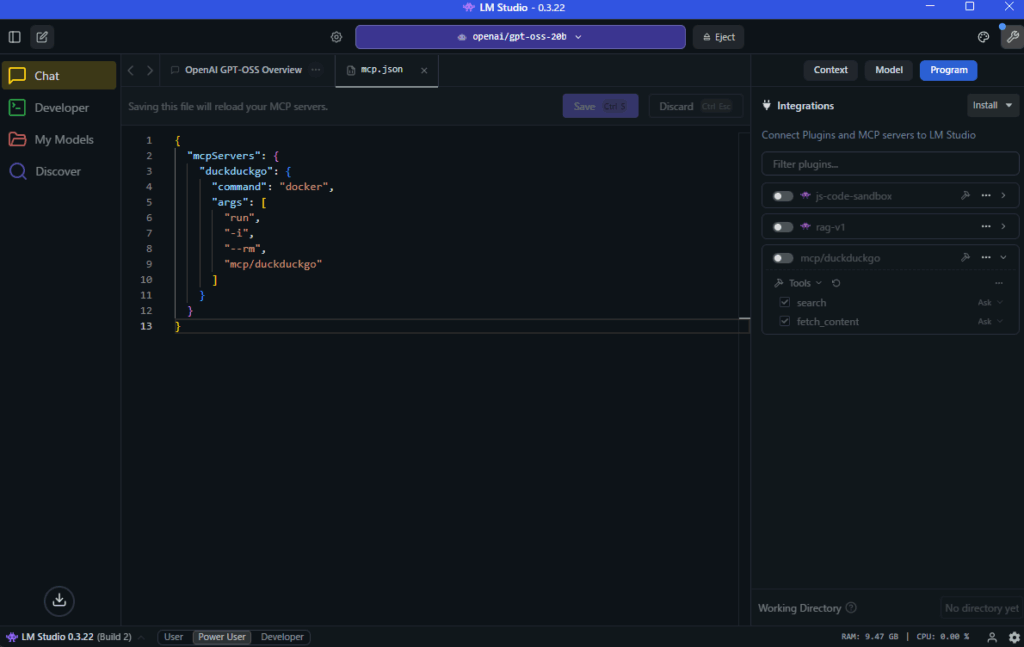

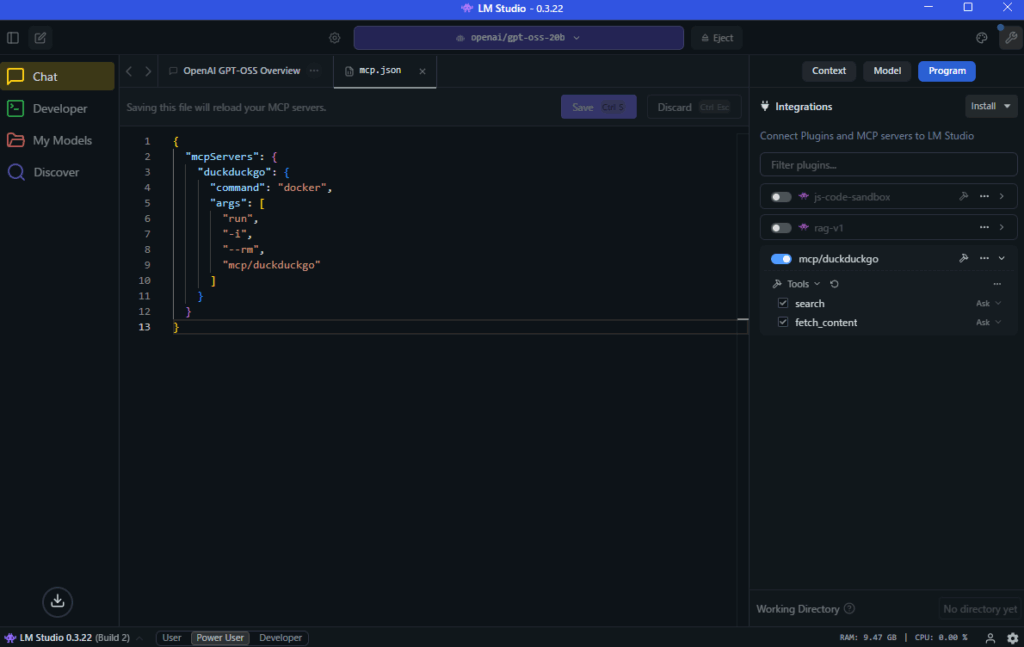

LM studio gpt-oss 20bでの作業

WindowsでLM Studioを使ってローカルでgpt-oss-20bを動かすの記事を参考にして、LM Studioとgpt-oss-20bをインストールして使えるようにします。

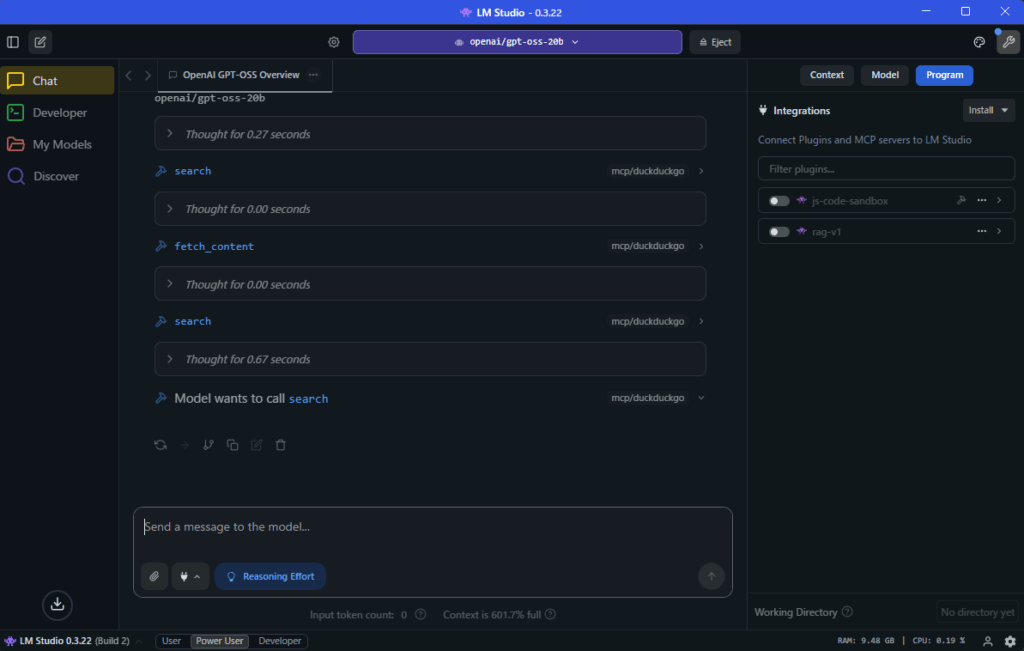

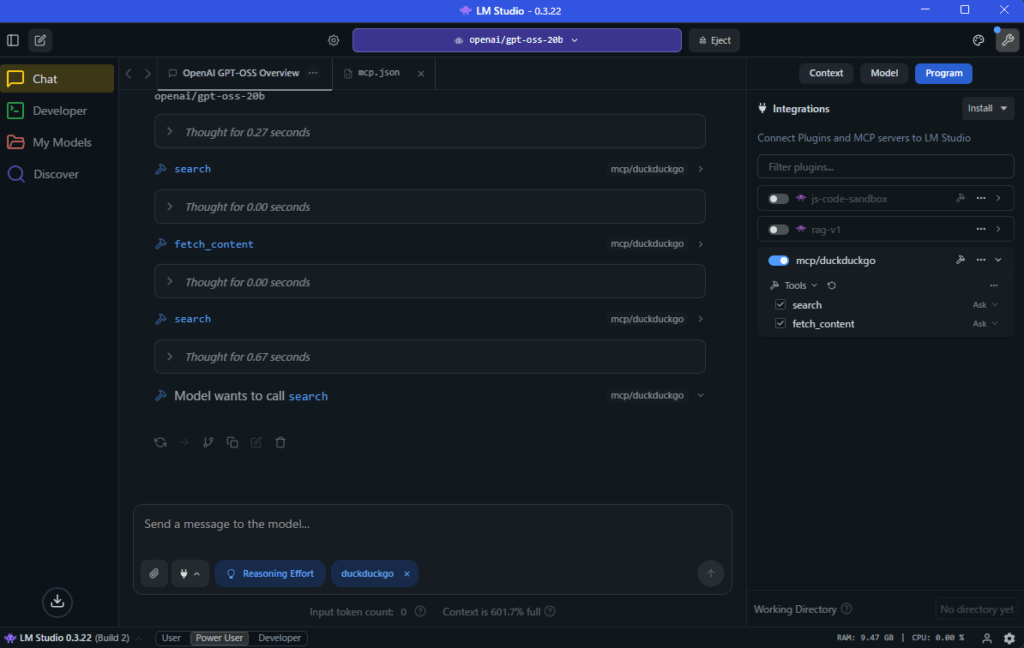

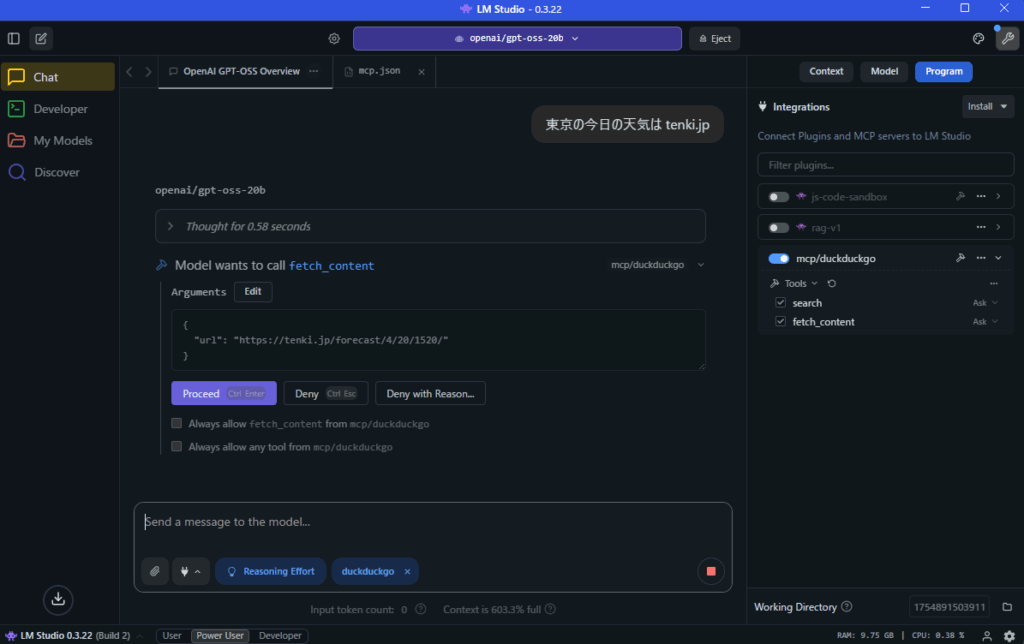

gpt-ossが、DuckDuckGoのfetch_contentを実行する確認画面を表示する。

Proceedが表示されたらクリックする。

Always allow fetch_content from mcp/duckduckgoにチェックすると、

以降は、DuckDuckGo MCPの fetch_content ツールに限っては、毎回許可を聞かずに自動実行する

Always allow any tool from mcp/duckduckgoにチェックすると、

以降は、このDuckDuckGo MCPが持つすべてのツールを自動実行する。

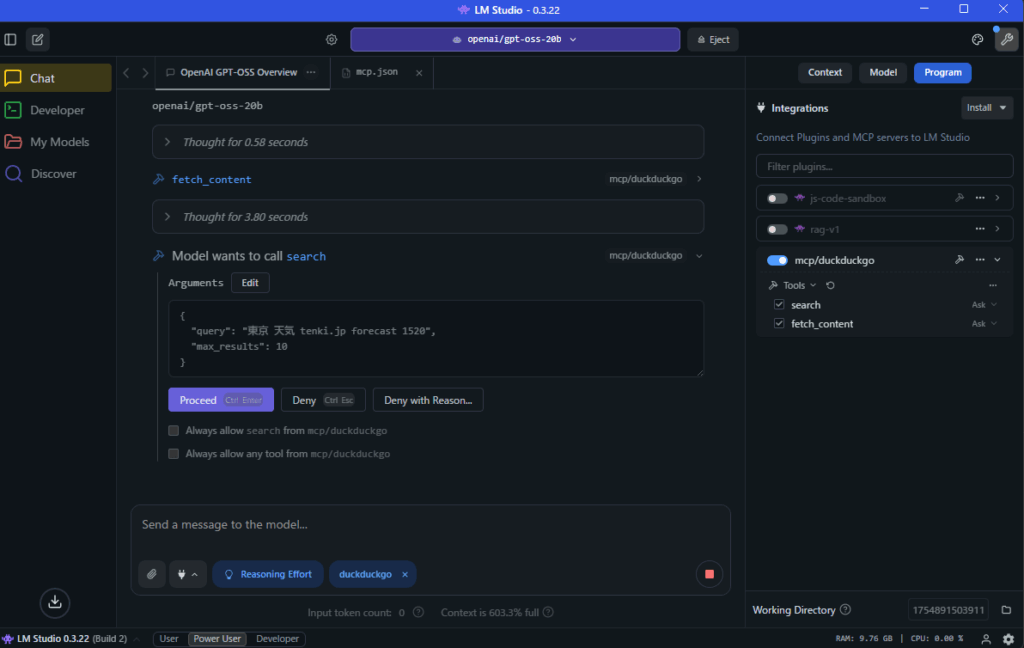

Proceedが表示されたらクリックする。

まとめ

本記事では、LM Studio にインストールした gpt-oss 20B に、Docker DesktopのMCP Toolkit を利用して DuckDuckGo MCPサーバー を導入し、Web検索機能を追加する手順を解説しました。

LM Studioとgpt-oss 20Bの概要から始まり、Docker DesktopでのMCPサーバーの設定方法、LM Studio側でのmcp.json編集・ツール許可設定、そして実際に検索・ページ要約を行う流れまでを順を追って紹介しました。

この構成を導入することで、ローカル環境で動作するLLMにインターネット検索機能を付与でき、最新情報を取得しながらの対話や特定サイトの情報を要約した応答が可能になります。

また、Always allow 設定を活用すれば、毎回の許可操作を省き、よりスムーズな検索・情報取得が行えます。

今後は、DuckDuckGo MCPサーバー以外のMCPツールを追加することで、ニュース取得、データベース連携、各種APIアクセスなど、用途に応じた機能拡張も可能です。

ぜひ本記事の手順を参考に、自分の環境に合ったMCPサーバー構成を構築し、ローカルLLMの利便性をさらに高めてみてください。